在人工智能领域,DeepSeek的崛起无疑是一个引人注目的现象。特别是公司旗下的DeepSeek-V3模型,以其卓越的性能和低成本训练的特点,引起了业界的广泛关注。这款模型的成功,不仅展示了AI技术的进步,也体现了在资源有限的情况下,通过创新和优化能够实现的突破。

让我们关注一下DeepSeek-V3的技术参数。根据技术报告,DeepSeek-V3拥有671B的参数量和37B的激活参数,预训练token量达到14.8万亿,这使得它在多项评测中超越了其他开源模型,如阿里的Qwen2.5-72B和Meta的DeLlama-3.1-405B。更令人印象深刻的是,DeepSeek-V3在性能上与世界上顶尖的闭源模型如GPT-4o和Claude-3.5-Sonnet相媲美。

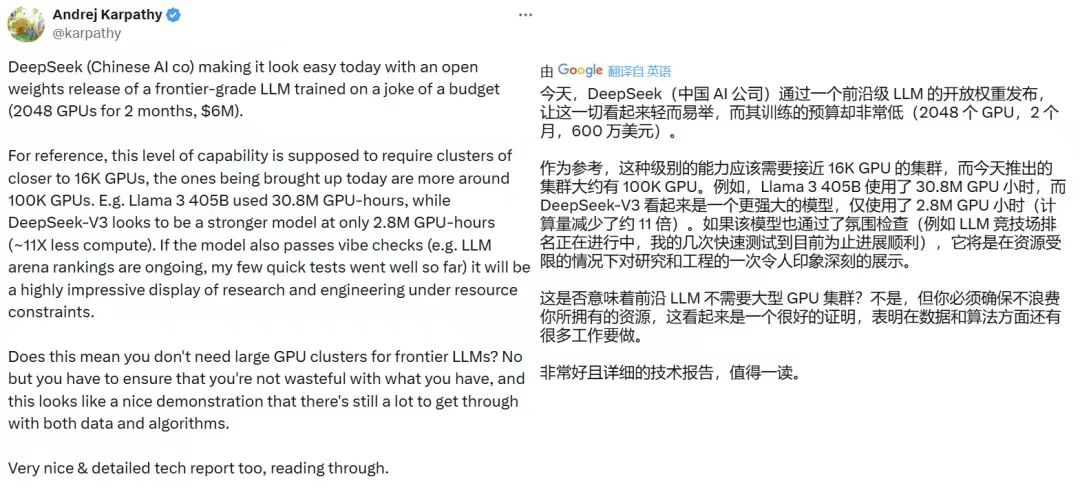

DeepSeek-V3的最大亮点在于其训练成本。前OpenAI联创、AI科学家Andrej Karpathy提到,DeepSeek-V3的训练过程仅使用了不到280万GPU小时,这与Meta的Llama-3405B模型相比,后者的训练时长是3080万GPU小时。如果考虑到成本,DeepSeek-V3的总训练成本不到600万美元,而Llama-3405B的训练成本则超过6000万美元,这意味着DeepSeek-V3的成本效益比极高。

Meta的AI研究科学家田渊栋和ScaleAI的创始人兼CEO Alexandr Wang都对DeepSeek-V3在有限预算下实现的强劲表现表示赞赏。他们认为,DeepSeek-V3能够以更低的成本、更快的速度和更强的实力迎头赶上,这是一项了不起的成就。

DeepSeek的技术进步和成本控制能力,得益于其创新的架构设计。DeepSeek-V2采用了MLA(多头潜在注意力)和DeepSeekMoE架构等创新技术,这些技术提高了训练的经济性和推理效率。DeepSeek也是国内最早开启大模型降价的厂商,引领了大模型价格战,促使其他厂商如字节、阿里、百度等跟进降价。

在硬件资源方面,DeepSeek是中国互联网大厂以外,唯一一家储备了万张A100芯片的公司,这为其技术研发提供了坚实的算力基础。DeepSeek的创始人梁文锋,一位毕业于浙江大学电子工程系的80后,始终保持着低调的作风,专注于技术研发。他和他的团队以200人左右的小团队,不依靠外部融资,成功开发出了一个具有高性价比并被全球AI界认可的大模型。

DeepSeek-V3的成功不仅仅是技术上的突破,更是在资源有限的条件下通过创新和优化实现的一次卓越展示。它的出现不仅推动了大语言模型的发展,也为全球AI行业提供了新的发展思路和可能性。

本文来自作者[shyfzc]投稿,不代表艺帆号立场,如若转载,请注明出处:https://vip.shyfzc.com/zixue/202412-26697.html

评论列表(4条)

我是艺帆号的签约作者“shyfzc”!

希望本篇文章《95后AI 天才少女 刷屏!雷军千万年薪挖角! (95后现象)》能对你有所帮助!

本站[艺帆号]内容主要涵盖:国足,欧洲杯,世界杯,篮球,欧冠,亚冠,英超,足球,综合体育

本文概览:在人工智能领域,DeepSeek的崛起无疑是一个引人注目的现象,特别是公司旗下的DeepSeek,V3模型,以其卓越的性能和低成本训练的特点,引起了业界的广泛关注,这款模型的成...